- Tester la signification des corrélations

- 1. La comparaison des corrélations à partir d’échantillons indépendants

- 2. Comparaison des corrélations à partir d’échantillons dépendants

- 3. Test de l’indépendance linéaire (Test par rapport à 0)

- 4. Test des corrélations par rapport à une valeur fixe

- 5. Calcul des intervalles de confiance des corrélations

- 6. Transformation de Fisher-Z

- 7. Calcul du coefficient de corrélation Phi rPhi pour les données binaires

- 8. Calcul de la moyenne pondérée d’une liste de corrélations

- 9. La transformation des tailles d’effet r, d, f, Rapport de cotes et les corrélations au carré eta

- 10. Calcul des corrélations linéaires

- Littérature

Tester la signification des corrélations

- Comparaison des corrélations d’échantillons indépendants

- Comparaison des corrélations d’échantillons dépendants

- Test d’indépendance linéaire (Test contre 0)

- Test de corrélations contre une valeur fixe

- Calcul des intervalles de confiance des corrélations

- Transformation de Fisher-Z

- Calcul du coefficient de corrélation Phi rPhi pour les données catégoriales

- Calcul de la moyenne pondérée d’une liste de corrélations

- Transformation des tailles d’effet r, d, f, Rapport de cotes et carré eta

- Calcul des Corrélations linéaires

1. La comparaison des corrélations à partir d’échantillons indépendants

Corrélations, qui ont été extraites de différents échantillons peuvent être testées les unes contre les autres. Exemple: Imaginez, vous voulez tester, si les hommes augmentent leurs revenus beaucoup plus rapidement que les femmes. Vous pouvez par exemple collecter les données sur l’âge et le revenu de 1 200 hommes et 980 femmes. La corrélation pourrait s’élever à r=.38 dans la cohorte masculine et r =.31 chez les femmes. Y a-t-il une différence significative dans la corrélation des deux cohortes?

| n | r | |

| Corrélation 1 | ||

| Corrélation 2 | ||

| Statistique de test z | ||

| Probabilité p | ||

( Calcul selon Eid, Gollwitzer & Schmidt, 2011, pp. 547; test simple face)

2. Comparaison des corrélations à partir d’échantillons dépendants

Si plusieurs corrélations ont été extraites du même échantillon, cette dépendance dans les données peut être utilisée pour augmenter la puissance du test de signification. Considérons l’exemple fictif suivant:

- 85 les enfants de 3e année ont été testés avec des tests sur l’intelligence (1), les capacités arithmétiques (2) et la compréhension de la lecture (3). La corrélation entre intelligence et capacités arithmétiques s’élève à r12 =.53, l’intelligence et la lecture sont en corrélation avec r13 =.41 et arithmétique et lecture avec r23 =.59. La corrélation entre l’intelligence et les capacités arithmétiques est-elle supérieure à la corrélation entre l’intelligence et la compréhension de la lecture?

| n | r12 | r13 | r23 |

| Statistique de test z | |||

| Propabilité p | |||

( Calcul selon Eid et al., 2011, S. 548 f.; essais à simple face)

3. Test de l’indépendance linéaire (Test par rapport à 0)

Avec le calculateur suivant, vous pouvez tester si les corrélations sont différentes de zéro. Le test est basé sur la distribution t de l’étudiant avec n- 2 degrés de liberté. Un exemple: La longueur du pied gauche et du nez de 18 hommes est quantifiée. La longueur est en corrélation avec r =.69. La corrélation est-elle significativement différente de 0?

| n | r |

| Statistique de test t | |

| Propabilité p (simple face) | |

| Propabilité p (recto-verso) |

( Calcul selon Eid et al., 2011, S. 542; essai bilatéral)

4. Test des corrélations par rapport à une valeur fixe

Avec le calculateur suivant, vous pouvez tester si les corrélations sont différentes d’une valeur fixe. Le test utilise la transformation de Fisher-Z.

| n | r | ρ (valeur, la corrélation est testée contre) |

| Statistique de test z | ||

| Propabilité p | ||

( Calcul selon Eid et al., 2011, S. 543f.; essai bilatéral)

5. Calcul des intervalles de confiance des corrélations

L’intervalle de confiance spécifie la plage de valeurs qui inclut une corrélation avec une probabilité donnée (coefficient de confiance). Plus le coefficient de confiance est élevé, plus l’intervalle de confiance est grand. Généralement, les valeurs autour.9 sont utilisés.

| n | r | Confiance Coefficient |

|

| Intervalle de confiance | |||

( Calcul selon Eid et al., 2011, S. 545f.; test bilatéral)

Le calcul devient imprécis avec de grandes tailles d’échantillons et des valeurs de corrélation extrêmes en raison de la précision restreinte des nombres à virgule flottante en Javascript.

6. Transformation de Fisher-Z

La transformation de Fisher-Z convertit les corrélations en une mesure presque normalement distribuée. Il est nécessaire pour de nombreuses opérations avec des corrélations, par exemple lors de la moyenne d’une liste de corrélations. Le convertisseur suivant transforme les corrélations et calcule également les opérations inverses. Veuillez noter que le Fisher-Z est tapé en majuscules.

| Valeur | Transformation | Résultat |

7. Calcul du coefficient de corrélation Phi rPhi pour les données binaires

rPhi est une mesure pour les données binaires telles que les dénombrements dans différentes catégories, par exemple réussir / échouer à un examen des hommes et des femmes. Il est également appelé coefficient de contingence ou Phi de Yule. La transformation en dCohen se fait via le calculateur de taille d’effet.

| Groupe 1 | Groupe 2 | |

| Catégorie 1 | ||

| Catégorie 2 | ||

| rPhi | ||

| Taille de l’effet dcohen | ||

8. Calcul de la moyenne pondérée d’une liste de corrélations

En raison de la distribution de biais des corrélations (voir Transformation de Fisher-Z), la moyenne d’une liste de corrélations ne peut pas simplement être calculée en construisant la moyenne arithmétique. Habituellement, les corrélations sont transformées en valeurs de Fisher-Z et pondérées par le nombre de cas avant de faire la moyenne et de se retransformer avec un Fisher-Z inverse. Bien qu’il s’agisse de l’approche habituelle, Eid et al. (2011, pp. 544) suggèrent d’utiliser plutôt la correction d’Olkin & Pratt (1958), comme les simulations l’ont montré pour estimer plus précisément la corrélation moyenne. La calculatrice suivante calcule à la fois pour vous, « l’approche traditionnelle de Fisher-Z » et l’algorithme d’Olkin et de Pratt.

| rFisher Z | rOlkin & Pratt | |

Veuillez remplir les corrélations dans la colonne A et le nombre de cas dans la colonne B. Vous pouvez également copier les valeurs des tables de votre tableur. Enfin, cliquez sur « OK » pour lancer le calcul. Certaines valeurs déjà renseignées à des fins de démonstration.

9. La transformation des tailles d’effet r, d, f, Rapport de cotes et les corrélations au carré eta

sont une mesure de taille d’effet. Ils quantifient l’ampleur d’un effet empirique. Il existe également un certain nombre d’autres mesures de la taille des effets, le dCohen étant probablement le plus important. Les différentes mesures de taille d’effet peuvent être converties en une autre. Veuillez consulter les calculatrices en ligne sur la page Calcul des tailles d’effets.

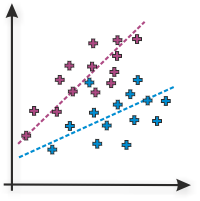

10. Calcul des corrélations linéaires

Le calculateur en ligne calcule les corrélations linéaires de pearson ou de moment produit de deux variables. Veuillez remplir les valeurs de la variable 1 dans la colonne A et les valeurs de la variable 2 dans la colonne B et appuyez sur ‘OK’. En guise de démonstration, les valeurs d’une corrélation positive élevée sont déjà renseignées par défaut.

| Données | linéaire Corrélation rPearson |

Détermination coefficient r2 |

Interprétation |

Littérature

De nombreux tests d’hypothèse sur cette page sont basés sur Eid et al. (2011). jStat est utilisé pour générer la distribution t de Student pour tester les corrélations les unes par rapport aux autres. L’élément de feuille de calcul est basé sur Handsontable.

- Eid, M., Gollwitzer, M., & Schmitt, M. (2011). Statistik und Forschungsmethoden Lehrbuch. Weinheim : Beltz.

Veuillez utiliser la citation suivante: Lenhard, W. & Lenhard, A. (2014). Tests d’hypothèses pour Comparer les Corrélations. disponible: https://www.psychometrica.de/correlation.html. Bibergau (Allemagne) : Psychometrica. DOI: 10.13140/RG.2.1.2954.1367