- Testen der Signifikanz von Korrelationen

- 1. Vergleich von Korrelationen aus unabhängigen Stichproben

- 2. Vergleich von Korrelationen aus abhängigen Stichproben

- 3. Testen der linearen Unabhängigkeit (Testen gegen 0)

- 4. Testen von Korrelationen gegen einen festen Wert

- 5. Berechnung von Konfidenzintervallen von Korrelationen

- 6. Fisher-Z-Transformation

- 7. Berechnung des Phi-Korrelationskoeffizienten rPhi für Binärdaten

- 8. Berechnung des gewichteten Mittelwerts einer Korrelationsliste

- 9. Transformation der Effektgrößen r, d, f, Odds Ratio Und eta square

- 10. Berechnung linearer Korrelationen

- Literatur

Testen der Signifikanz von Korrelationen

- Vergleich von Korrelationen aus unabhängigen Stichproben

- Vergleich von Korrelationen aus abhängigen Stichproben

- Testen der linearen Unabhängigkeit (Testen gegen 0)

- Testen von Korrelationen gegen einen festen Wert

- Berechnung von Konfidenzintervallen von Korrelationen

- Fisher-Z-Transformation

- Berechnung des Phi-Korrelationskoeffizienten rPhi für kategoriale Daten

- Berechnung des gewichteten Mittelwerts einer Liste von korrelationen

- Transformation der Effektgrößen r, d, f, Odds Ratio und eta square

- Berechnung linearer Korrelationen

1. Vergleich von Korrelationen aus unabhängigen Stichproben

Korrelationen, die aus verschiedenen Stichproben gewonnen wurden, können gegeneinander getestet werden. Beispiel: Stellen Sie sich vor, Sie möchten testen, ob Männer ihr Einkommen deutlich schneller steigern als Frauen. Sie könnten z. B. die Daten zu Alter und Einkommen von 1 200 Männern und 980 Frauen sammeln. Die Korrelation könnte r = betragen.38 in der männlichen Kohorte und r = .31 bei Frauen. Gibt es einen signifikanten Unterschied in der Korrelation beider Kohorten?

| n | r | |

| Korrelation 1 | ||

| Korrelation 2 | ||

| Teststatistik z | ||

| Wahrscheinlichkeit p | ||

( Berechnung nach Eid, Gollwitzer & Schmidt, 2011, S. 547; einseitiger Test)

2. Vergleich von Korrelationen aus abhängigen Stichproben

Wenn mehrere Korrelationen aus derselben Stichprobe abgerufen wurden, kann diese Abhängigkeit innerhalb der Daten verwendet werden, um die Aussagekraft des Signifikanztests zu erhöhen. Betrachten Sie das folgende fiktive Beispiel:

- 85 kinder ab der 3. Klasse wurden mit Tests auf Intelligenz (1), Rechenfähigkeiten (2) und Leseverständnis (3) getestet. Die Korrelation zwischen Intelligenz und Rechenfähigkeiten beträgt r12 = .53, intelligenz und Lesen korreliert mit r13 = .41 und Rechnen und Lesen mit r23 = .59. Ist die Korrelation zwischen Intelligenz und arithmetischen Fähigkeiten höher als die Korrelation zwischen Intelligenz und Leseverständnis?

| n | r12 | r13 | r23 |

| Teststatistik z | |||

| Wahrscheinlichkeit p | |||

( Berechnung nach Eid et al., 2011, S. 548 f.; einseitige Prüfung)

3. Testen der linearen Unabhängigkeit (Testen gegen 0)

Mit dem folgenden Rechner können Sie testen, ob Korrelationen von Null verschieden sind. Der Test basiert auf der t-Verteilung des Schülers mit n – 2 Freiheitsgraden. Ein Beispiel: Die Länge des linken Fußes und der Nase von 18 Männern wird quantifiziert. Die Länge korreliert mit r = .69. Unterscheidet sich die Korrelation signifikant von 0?

| n | r |

| Teststatistik t | |

| Propability p (einseitig) | |

| Propability p (zweiseitig) |

( Berechnung nach Eid et al., 2011, S. 542; zweiseitiger Test)

4. Testen von Korrelationen gegen einen festen Wert

Mit dem folgenden Rechner können Sie testen, ob Korrelationen von einem festen Wert abweichen. Der Test verwendet die Fisher-Z-Transformation.

| n | r | ρ (Wert, die Korrelation wird gegen) |

| Teststatistik z | ||

| Wahrscheinlichkeit p | ||

( Berechnung nach Eid et al., 2011, S. 543f.; zweiseitiger Test)

5. Berechnung von Konfidenzintervallen von Korrelationen

Das Konfidenzintervall gibt den Wertebereich an, der eine Korrelation mit einer bestimmten Wahrscheinlichkeit (Konfidenzkoeffizient) enthält. Je höher der Konfidenzkoeffizient, desto größer das Konfidenzintervall. Allgemein, Werte herum .9 verwendet werden.

| n | r | Vertrauen Koeffizient |

|

| Konfidenzintervall | |||

( Berechnung nach Eid et al., 2011, S. 545f.; two sided test)

Die Berechnung wird bei großen Stichprobengrößen und extremen Korrelationswerten aufgrund der eingeschränkten Genauigkeit von Gleitkommazahlen in Javascript ungenau.

6. Fisher-Z-Transformation

Die Fisher-Z-Transformation wandelt Korrelationen in ein nahezu normalverteiltes Maß um. Es ist für viele Operationen mit Korrelationen notwendig, z. B. bei der Mittelung einer Korrelationsliste. Der folgende Konverter transformiert die Korrelationen und berechnet auch die inversen Operationen. Bitte beachten Sie, dass das A-Z in Großbuchstaben geschrieben ist.

| Wert | Transformation | Ergebnis |

7. Berechnung des Phi-Korrelationskoeffizienten rPhi für Binärdaten

rPhi ist ein Maß für Binärdaten wie Zählungen in verschiedenen Kategorien, z. B. Bestehen / Nichtbestehen in einer Prüfung von Männern und Frauen. Es wird auch Kontingenzkoeffizient oder Yules Phi genannt. Die Umwandlung in dCohen erfolgt über den Effektgrößenrechner.

| Gruppe 1 | Gruppe 2 | |

| Kategorie 1 | ||

| Kategorie 2 | ||

| rPhi | ||

| Wirkung Größe dcohen | ||

8. Berechnung des gewichteten Mittelwerts einer Korrelationsliste

Aufgrund der Schiefverteilung der Korrelationen (siehe Fisher-Z-Transformation) kann der Mittelwert einer Korrelationsliste nicht einfach durch Bildung des arithmetischen Mittels berechnet werden. Üblicherweise werden Korrelationen in Fisher-Z-Werte transformiert und mit der Anzahl der Fälle gewichtet, bevor sie gemittelt und mit einem inversen Fisher-Z rücktransformiert werden. (2011, S. 544) schlagen vor, stattdessen die Korrektur von Olkin & Pratt (1958) zu verwenden, wie Simulationen zeigten, um die mittlere Korrelation genauer abzuschätzen. Der folgende Rechner berechnet für Sie sowohl den „traditionellen Fisher-Z-Ansatz“ als auch den Algorithmus von Olkin und Pratt.

| rFisher Z | rOlkin & Pratt | |

Bitte füllen Sie die Zusammenhänge in Spalte A und die Anzahl der Fälle in Spalte B aus. Sie können die Werte auch aus Tabellen Ihres Tabellenkalkulationsprogramms kopieren. Klicken Sie abschließend auf „OK“, um die Berechnung zu starten. Einige Werte bereits zu Demonstrationszwecken ausgefüllt.

9. Transformation der Effektgrößen r, d, f, Odds Ratio Und eta square

Korrelationen sind ein Effektgrößenmaß. Sie quantifizieren das Ausmaß eines empirischen Effekts. Es gibt auch eine Reihe anderer Effektgrößenmaße, wobei dCohen wahrscheinlich die prominenteste ist. Die verschiedenen Effektgrößenmaße können in ein anderes umgewandelt werden. Bitte schauen Sie sich die Online-Rechner auf der Seite Berechnung von Effektgrößen an.

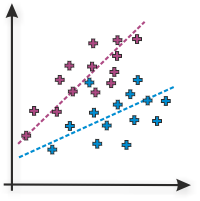

10. Berechnung linearer Korrelationen

Der Online-Rechner berechnet lineare Pearson- oder Produktmomentkorrelationen zweier Variablen. Bitte geben Sie die Werte der Variablen 1 in Spalte A und die Werte der Variablen 2 in Spalte B ein und drücken Sie ‚OK‘. Als Demonstration werden Werte für eine hohe positive Korrelation bereits standardmäßig ausgefüllt.

| Daten | linear Korrelation rPearson |

Bestimmung Koeffizient r2 |

Interpretation |

Literatur

Viele Hypothesentests auf dieser Seite basieren auf Eid et al. (2011). jStat wird verwendet, um die T-Verteilung des Schülers zum Testen von Korrelationen gegeneinander zu generieren. Das Spreadsheet-Element basiert auf Handsontable.

- Eid, M., Gollwitzer, M., & Schmitt, M. (2011). Statistik und Forschungsmethoden Lehrbuch. Weinheim: Beltz.

Bitte verwenden Sie folgendes Zitat: Lenhard, W. & Lenhard, A. (2014). Hypothesentests zum Vergleich von Korrelationen. verfügbar: https://www.psychometrica.de/correlation.html. Bibergau (Deutschland): Psychometrica. Ursprungsbezeichnung: 10.13140/RG.2.1.2954.1367