- Probar la Importancia de las Correlaciones

- 1. La comparación de correlaciones de muestras independientes

- 2. Comparación de correlaciones de muestras dependientes

- 3. Prueba de independencia lineal (Prueba contra 0)

- 4. Probar correlaciones con un valor fijo

- 5. Cálculo de intervalos de confianza de correlaciones

- 6. Transformación Fisher-Z

- 7. Cálculo del coeficiente de correlación Phi rPhi para datos binarios

- 8. Cálculo de la media ponderada de una lista de correlaciones

- 9. Transformación de los tamaños de efecto r, d, f, Odds Ratioand eta cuadrado

- 10. Cálculo de Correlaciones Lineales

- La literatura

Probar la Importancia de las Correlaciones

- Comparación de correlaciones de muestras independientes

- Comparación de correlaciones de muestras dependientes

- Prueba de independencia lineal (Prueba contra 0)

- Prueba de correlaciones contra un valor fijo

- Cálculo de intervalos de confianza de correlaciones

- Transformación Fisher-Z

- Cálculo del coeficiente de correlación Phi rPhi para datos categoriales

- Cálculo de la media ponderada de una lista de correlaciones

- Transformación de los tamaños de efecto r, d, f, Razón de Odds y eta cuadrado

- Cálculo de Correlaciones Lineales

1. La comparación de correlaciones de muestras independientes

Las correlaciones que se han obtenido de diferentes muestras se pueden comparar entre sí. Ejemplo: Imagine, que desea probar, si los hombres aumentan sus ingresos considerablemente más rápido que las mujeres. Por ejemplo, podría recopilar datos sobre la edad y los ingresos de 1.200 hombres y 980 mujeres. La correlación podría ascender a r = .38 en la cohorte masculina y r = .31 en mujeres. Hay una diferencia significativa en la correlación de ambas cohortes?

| n | r | |

| Correlación 1 | ||

| Correlación 2 | ||

| Estadística de Prueba z | ||

| Probabilidad p | ||

(Cálculo según Eid, Gollwitzer & Schmidt, 2011, pp. 547; prueba de un solo lado)

2. Comparación de correlaciones de muestras dependientes

Si se han obtenido varias correlaciones de la misma muestra, esta dependencia dentro de los datos puede utilizarse para aumentar la potencia de la prueba de significancia. Considere el siguiente ejemplo ficticio:

- 85 los niños de grado 3 han sido evaluados con pruebas de inteligencia (1), habilidades aritméticas (2) y comprensión de lectura (3). La correlación entre inteligencia y habilidades aritméticas asciende a r12 = .53, inteligencia y lectura se correlaciona con r13 = .41 y aritmética y lectura con r23 = .59. ¿La correlación entre inteligencia y habilidades aritméticas es mayor que la correlación entre inteligencia y comprensión lectora?

| n | r12 | r13 | r23 |

| Estadístico de Prueba z | |||

| Propability p | |||

(Cálculo de acuerdo a Eid et al., 2011, S. 548 f.; prueba de un solo lado)

3. Prueba de independencia lineal (Prueba contra 0)

Con la siguiente calculadora, puede probar si las correlaciones son diferentes de cero. La prueba se basa en la distribución t del Estudiante con n – 2 grados de libertad. Un ejemplo: Se cuantifica la longitud del pie izquierdo y la nariz de 18 hombres. La longitud se correlaciona con r = .69. La correlación es significativamente diferente de 0?

| n | r |

| Prueba Estadística de t | |

| Propability p (de una sola cara) | |

| Propability p (dos caras) |

(Cálculo de acuerdo a Eid et al., 2011, S. 542; prueba de dos lados)

4. Probar correlaciones con un valor fijo

Con la siguiente calculadora, puede probar si las correlaciones son diferentes de un valor fijo. La prueba utiliza la transformación Fisher-Z.

| n | r | ρ (valor, la correlación es probado contra) |

| Estadístico de Prueba z | ||

| Propability p | ||

(Cálculo de acuerdo a Eid et al., 2011, S. 543f.; prueba de dos lados)

5. Cálculo de intervalos de confianza de correlaciones

El intervalo de confianza especifica el rango de valores que incluye una correlación con una probabilidad dada (coeficiente de confianza). Cuanto mayor sea el coeficiente de confianza, mayor será el intervalo de confianza. Comúnmente, valores alrededor .se utilizan 9.

| n | r | Confianza Coeficiente de |

|

| intervalo de Confianza | |||

(Cálculo de acuerdo Eid et al., 2011, S. 545f.; prueba de dos caras)

El cálculo se vuelve impreciso con tamaños de muestra grandes y valores de correlación extremos debido a la precisión restringida de los números de coma flotante en Javascript.

6. Transformación Fisher-Z

La transformación Fisher-Z convierte las correlaciones en una medida distribuida casi normalmente. Es necesario para muchas operaciones con correlaciones, por ejemplo, cuando se promedia una lista de correlaciones. El siguiente convertidor transforma las correlaciones y también calcula las operaciones inversas. Tenga en cuenta que Fisher-Z está escrito en mayúsculas.

| Valor | Transformación | Resultado |

7. Cálculo del coeficiente de correlación Phi rPhi para datos binarios

rPhi es una medida para datos binarios como recuentos en diferentes categorías, por ejemplo, aprobar/reprobar en un examen de hombres y mujeres. También se llama coeficiente de contingencia o Phi de Navidad. La transformación a dCohen se realiza a través de la calculadora de tamaño de efecto.

| Grupo 1 | Grupo 2 | |

| Categoría 1 | ||

| Categoría 2 | ||

| rPhi | ||

| el Tamaño del Efecto dcohen | ||

8. Cálculo de la media ponderada de una lista de correlaciones

Debido a la distribución torcida de las correlaciones(véase Transformación Fisher-Z), la media de una lista de correlaciones no puede calcularse simplemente construyendo la media aritmética. Por lo general, las correlaciones se transforman en valores de Fisher-Z y se ponderan por el número de casos antes de promediar y retransformar con un Fisher-Z inverso.Aunque este es el enfoque habitual, Eid et al. (2011, pp.544) sugieren usar la corrección de Olkin & Pratt (1958) en su lugar, ya que las simulaciones lo mostraron para estimar la correlación media con mayor precisión. La siguiente calculadora calcula para usted, el «enfoque tradicional de Fisher-Z» y el algoritmo de Olkin y Pratt.

| rFisher Z | rOlkin & Pratt | |

Rellene las correlaciones en la columna A y el número de casos en la columna B. También puede copiar los valores de las tablas de su programa de hoja de cálculo. Finalmente, haga clic en «Aceptar» para iniciar el cálculo. Algunos valores ya se han rellenado con fines de demostración.

9. Transformación de los tamaños de efecto r, d, f, Odds Ratioand eta cuadrado

Las correlaciones son una medida de tamaño de efecto. Cuantifican la magnitud de un efecto empírico. También hay una serie de otras medidas de tamaño de efectos, siendo dCohen probablemente la más prominente. Las diferentes medidas de tamaño de efecto se pueden convertir en otra. Por favor, eche un vistazo a las calculadoras en línea en la página Cálculo de Tamaños de efectos.

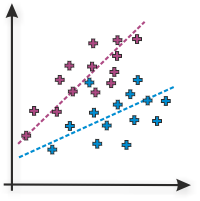

10. Cálculo de Correlaciones Lineales

La calculadora en línea calcula correlaciones lineales de Pearson o de momento de producto de dos variables. Rellene los valores de la variable 1 en la columna A y los valores de la variable 2 en la columna B y presione ‘OK’. Como demostración, los valores de una correlación positiva alta ya se rellenan de forma predeterminada.

| Datos | lineal Correlación rPearson |

Determinación coeficiente r2 |

Interpretación |

La literatura

Muchas pruebas de hipótesis en esta página se basan en Eid et al. (2011). jStat se utiliza para generar la distribución t de Student para probar correlaciones entre sí. El elemento de hoja de cálculo se basa en Handsontable.

- Eid, M., Gollwitzer, M., & Schmitt, M. (2011). Statistik und Forschungsmethoden Lehrbuch. Weinheim: Beltz.

Utilice la siguiente cita: Lenhard, W. & Lenhard, A. (2014). Pruebas de Hipótesis para Comparar Correlaciones. disponible: https://www.psychometrica.de/correlation.html. Bibergau (Alemania): Psychometrica. DOI: 10.13140 / RG.2.1.2954.1367